Paper: http://staff.ustc.edu.cn/~hexn/papers/sigir22-InterD.pdf

PR113 Facebook group: https://www.facebook.com/groups/565858127904979

1. 추천 모델이 popularity bias 문제를 안고 있다는 것은 널리 알려진 사실

- Yahoo!R3 dataset 등의 경우 RCT dataset이 존재함

- Unbiased test set이라고 생각하면 편함

- 일반 dataset의 test set과 RCT dataset의 test set에서 둘 다 좋은 성능을 보이는 모델이 부족함

- Trade-off 관계에서 벗어나서, 둘 다 좋은 성능을 보이는 모델을 만들자!

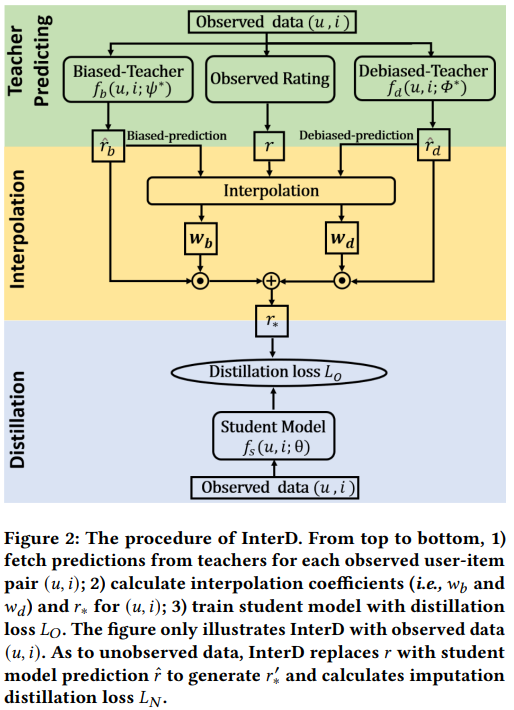

2. Biased test set과 unbiased test set에 각각 강한 모델을 가지고 합치면 어떨까?

- 단순 ensemble은 각 모델이 어떤 user/item에 강한지 파악하기도 힘들고, 적당한 ensemble 기법 찾기 힘듦

- Interaction 단위로 쪼개서, 주어진 interaction에 대해 어떤 모델이 더 적합한지 판단해보자

- Distillation을 통해 최종 모델이 각 pair에 대해 더 적합한 모델의 지식을 더 많이 받아들이도록 학습

- 학습에 사용되는 data로는 일반 training set + debiased(RCT) training set을 사용함

- 각 pair에 대해 biased model, debiased model의 loss를 구하고, loss가 더 작은 쪽의 정보가 더 많이 distillation되도록 weight를 가함(논문 eq.2, 4)

- Missing data 또한 모델이 포함할 수 있도록 사용

- Student model이 만든 missing data에 대한 prediction이 biased/debiased model이 각각 만든 prediction 중 어디와 더 가까운지 판단해서, 가까운 쪽의 정보를 더 많이 받아들이도록 distillation(논문 eq. 6, 7)

- 논문에서는 초기에 더 쉬운(loss가 더 가까운) data에 대한 정보를 많이 학습해서 self-paced learning과 비슷하다고...

3. 기존 존재했던 debiasing model의 경우 일반 test set에, 일반 모델의 경우 debiased(RCT) test set에 약했는데, 이 모델은 둘 다 기존 방법 대비 좋은 성능을 보임

- Yahoo!R3 data 다뤘던 분에 따르면 이거 RCT training set이 없고 오직 RCT test set만 존재한다는데, 어떻게 RCT training set을 만들어서 사용했는지 설명이 불분명함